Un gruppo di ricerca italo-britannico ha sviluppato un sistema che, grazie all’AI, riesce a riconoscere in automatico una serie di elementi associati al nostro umore a partire da foto scattate con il telefono. Lo studio – pubblicato sulla rivista Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies – si basa sui dati raccolti attraverso MyMood, una app sviluppata per l’occasione dai ricercatori. I risultati ottenuti aprono la strada alla progettazione di applicazioni intelligenti basate sugli stati emotivi degli utenti, e non solo.

“Le tecniche proposte nel nostro lavoro possono essere implementate in una vasta gamma di applicazioni, spiega Mirco Musolesi, professore dell’Università di Bologna che ha coordinato lo studio. Ad esempio, potrebbero risultare utili per gestire il ritorno alla normalità dopo il lockdown dovuto alla crisi Covid-19: una condizione che per molti può risultare potenzialmente difficile dal punto di vista della salute mentale, e che quindi può portare ad un aumento dei casi di ansia e lieve depressione”.

Negli ultimi anni sono stati studiati diversi sistemi per derivare lo stato d’animo degli individui a partire da dati raccolti in tempo reale con dispositivi mobili: utilizzando ad esempio i dati GPS, oppure analizzando i post pubblicati sui social media, o ancora studiando le interazioni registrate dagli smartphone. Questa è però la prima volta che un gruppo di ricerca prova a sfruttare le informazioni legate all’ambiente in cui si trovano fisicamente le persone.

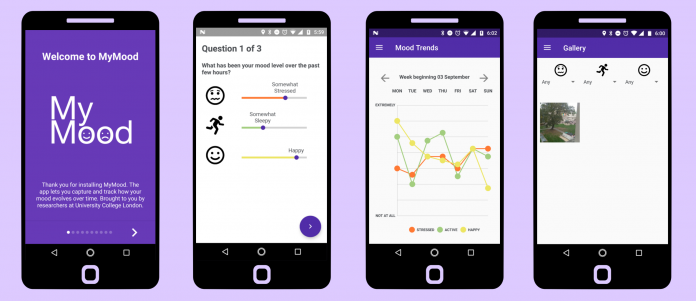

Per farlo gli studiosi hanno sviluppato MyMood, una app che in momenti casuali della giornata sottopone agli utenti un piccolo questionario sul loro stato emotivo, al termine del quale chiede di scattare una foto del luogo in cui si trovano. I ricercatori hanno così potuto analizzare, per un campione di 22 utenti, un totale di 3.305 questionari compilati e altrettante fotografie associate. I dati raccolti sono stati quindi processati da un sistema di deep learning basato su tecniche di intelligenza artificiale, che è riuscito ad individuare in automatico i singoli oggetti presenti nelle immagini.

Associando gli oggetti individuati con le informazioni sull’umore degli utenti, gli studiosi hanno così potuto evidenziare collegamenti tra stato psicologico e ambiente fisico. Ad esempio, la presenza di elementi tipici di un ufficio, come la tastiera di un computer, è associata ad un maggiore stress, mentre oggetti tipici dell’ambiente domestico – un letto o una televisione – sono associati ad un minore livello di “prontezza fisica”, e la presenza di un volto vicino è associata ad una maggiore felicità.

“È la prima volta che un’analisi di questo tipo, basata sulla rilevazione automatica di oggetti estratti da immagini della vita quotidiana degli utenti, viene realizzata, dice Victor-Alexandru Darvariu, primo autore dell’articolo che ha svolto questa ricerca durante una internship nel gruppo del professor Musolesi e sta ora svolgendo un dottorato sotto la sua supervisione. Questa metodologia può essere alla base di applicazioni intelligenti in grado di tenere sotto controllo ansia, depressione e altri problemi di tipo psicologico; ma anche in altri campi, ad esempio in architettura e nel design, per l’analisi e la progettazione di spazi interni ed esterni”.

E questi sistemi non sono limitati all’utilizzo attraverso smartphone: possono infatti trovare applicazioni anche in nuovi dispositivi tecnologici come gli smart glasses e altre tecnologie indossabili, in grado di catturare in automatico l’ambiente in cui si muovono gli utenti. Tutto questo, ovviamente, al netto degli aspetti di privacy, che restano fondamentali.

“Il nostro studio è stato realizzato nel rispetto di un protocollo etico e del Regolamento Generale per la Protezione dei Dati (GDPR), conferma Musolesi. La privacy è essenziale in questo tipo di ricerca: grazie ai sistemi di deep learning l’analisi delle immagini può essere effettuata direttamente sul dispositivo, ma in ogni caso si deve poter prevedere una totale anonimizzazione dell’identità dell’utente”.

Lo studio è stato pubblicato sulla rivista Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies con il titolo “Quantifying the Relationships between Everyday Objects and Emotional States through Deep Learning Based Image Analysis Using Smartphones”. Per l’Università di Bologna ha partecipato il professor Mirco Musolesi, docente al Dipartimento di Informatica – Scienza e Ingegneria. L’articolo sarà presentato in settembre alla “Joint Conference on Ubiquitous and Pervasive Computing (UbiComp 2020)”.