La rete edge continua a essere l’epicentro dell’innovazione nel data center. Lo confermano gli esperti di Vertiv secondo cui, nel 2019 l’attività nell’ambito dei data center si concentrerà proprio sull’innovazione a livello di edge.

Nei prossimi 12 mesi l’attenzione si concentrerà, dunque, su un potenziamento dell’intelligenza volto a semplificare i processi operativi, a supportare la gestione e l’assistenza remote e a colmare una sempre più marcata mancanza di competenze determinando una svolta radicale nel modello di elaborazione e gestione dei dati.

Da qui l’elenco dei 5 trend che caratterizzeranno i data center nel 2019.

- Semplificazione dell’edge – Una rete edge più intelligente, più semplice e autosufficiente va di pari passo con i trend del settore e dei consumatori, ad esempio l’Internet delle cose (IoT) e l’imminente lancio delle reti 5G, contribuendo ad avvicinare l’utente finale a tecnologie di computing potenti e a bassa latenza. Per molte aziende, l’edge è diventato l’elemento più mission critical del proprio ecosistema digitale. Sistemi intelligenti per la gestione dell’infrastruttura con funzionalità di machine learning utilizzati in combinazione con l’analisi basata sul cloud stanno infatti trasformando radicalmente la nostra concezione di edge computing e servizi edge. Si otterrà così una rete edge più solida ed efficiente con funzionalità di visibilità e riparazione automatica avanzate e con un minor coinvolgimento manuale.

- Rivoluzione sulla formazione dei dipendenti – Collaboratori in età avanzata prossima al pensionamento e programmi di formazione in ritardo rispetto all’evoluzione del data center e dell’edge stanno creando difficoltà a livello di competenze per i data center di tutto il pianeta. Nel 2019, quindi, verranno adottate misure per ovviare al problema. In primo luogo, le aziende inizieranno a modificare i processi di assunzione del personale destinato al data center, abbandonando i programmi di formazione tradizionali per preferire training più agili e specifici per il singolo job, con particolare attenzione per l’edge. Si prevede inoltre ulteriore formazione svolta internamente. In secondo luogo, le imprese implementeranno sistemi intelligenti e di machine learning per semplificare i processi operativi, salvaguardare le conoscenze istituzionali e supportare servizi di assistenza e manutenzione più predittivi ed efficienti.

- Sistemi UPS più intelligenti ed efficienti – Le nuove batterie apriranno opportunità per l’adozione su vasta scala di sistemi UPS capaci di interazioni più accurate con la rete. Nel breve periodo, questa tendenza si tradurrà in funzioni di gestione dei carichi e livellamento dei picchi. Le aziende finiranno poi per utilizzare parte dell’energia immagazzinata nei propri sistemi UPS per aiutare la società di fornitura dei servizi a ottimizzare la rete elettrica. L’immagazzinaggio statico di tutta questa energia è considerato da tempo un tema con notevoli potenziali in termini di generazione di ricavi. Ci stiamo avvicinando alle applicazioni mainstream.

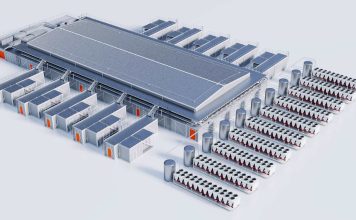

- Obiettivo normalizzazione – Anche nell’era del design modulare e prefabbricato, il data center rimane decisamente troppo complesso per prevedere la completa standardizzazione delle infrastrutture. Si registra, tuttavia, un interesse su due fronti: standardizzazione dei componenti delle apparecchiature e normalizzazione del data center. La seconda si manifesta nell’uso di architetture e tipologie di apparecchiature standard (seppur con differenze a seconda dell’area geografica) al fine di garantire la semplicità nella gestione dei sistemi e il controllo dei costi. In entrambi i casi, l’obiettivo è ridurre i costi delle infrastrutture, accelerare i tempi di implementazione ed erogazione dei servizi, semplificando anche le modalità di assistenza e manutenzione.

- Processori ad alta potenza e sistemi di raffreddamento avanzati – Man mano che aumenta il tasso di utilizzo dei processori per supportare applicazioni avanzate quali il riconoscimento facciale o l’analisi avanzata dei dati, i processori ad alta potenza richiedono approcci innovativi al thermal management. Il raffreddamento liquido diretto sul chip (con il processore o altri componenti parzialmente o totalmente immersi in un liquido per la dissipazione del calore) sta diventando una valida opportunità. Sebbene nella maggior parte dei casi questo metodo venga adottato per carichi di lavoro High Performance Computing (HPC), i vantaggi offerti (tra cui migliori prestazioni dei server, maggiore efficacia ad alte densità e costi di raffreddamento inferiori) giustificano un’attenta analisi. Un’altra area di innovazione nel comparto del thermal management è il raffreddamento estremo senz’acqua, un’alternativa sempre più diffusa rispetto al tradizionale utilizzo di acqua fredda.