“Da grandi poteri derivano grandi responsabilità” dice Ben Parker al nipote Peter, alias Spider-Man. Pur venendo da un fumetto questo è un insegnamento prezioso per noi che lavoriamo con dati e intelligenza artificiale. Il futuro dell’AI dipenderà dalla capacità di risolvere l’annosa questione dei bias, ovvero ciò che avviene quando le intelligenze artificiali provocano discriminazione sociale, come è avvenuto e avviene ancora oggi. Il tema non è nuovo, nella nostra comunità il dibattito è aperto, ma spesso affrontato in maniera non adeguata. La verità è che, al momento, non ci sono soluzioni reali, ma solo obiettivi da raggiungere sperimentando approcci diversi, perché i bias nell’AI sono un problema particolarmente complesso. Non è possibile, per esempio, dare un’unica definizione del bias: in statistica è la distanza tra la realtà e la stima che si fa; nel nostro mondo invece il bias non è uno scostamento da dati reali, ma nasce dal fatto che i dati stessi sono discriminatori, perché il pregiudizio è spesso insito nel sistema. Facciamo un esempio. Joy Buolamwini, una ricercatrice del MIT di Boston, nel suo studio “Gender Shades” ha verificato l’accuratezza di alcuni prodotti di riconoscimento facciale, arrivando alla conclusione che questi sistemi trattano alcune etnie in modo più impreciso rispetto alle altre. Nel caso specifico la ricerca ha dimostrato una precisione del 99% per gli uomini bianchi e una del 34% per le donne con una carnagione scura. Perché? Per il fatto che gli algoritmi usati da questi sistemi sono addestrati su immagini di soggetti prevalentemente maschili e di carnagione chiara.

Bias and prejudice

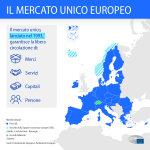

L’UE ha fatto sapere di voler pubblicare un Codice Etico grazie al quale l’intelligenza artificiale non dovrà mai danneggiare la dignità, la sicurezza fisica, psicologica e finanziaria delle persone. La proposta nasce perché tra i problemi emersi più frequentemente ci sono stati appunto molti casi di discriminazione razziale o di genere attraverso il riconoscimento facciale.

Nell’immaginario collettivo, le macchine sono percepite come perfettamente logiche e oggettive, lontane dalle passioni umane che spesso sviano il nostro giudizio. Viene naturale chiedersi: “Come può una macchina essere razzista o maschilista?”. La risposta è facile: gli algoritmi sono progettati da esseri umani e addestrati su dati prodotti da esseri umani, che risultano quasi sempre infarciti di bias, ad esempio per ragioni storiche (basti pensare a quanto la posizione sociale delle donne le abbia rese invisibili nei secoli scorsi). Come se non bastasse, l’intero contesto in cui viene sviluppata una soluzione di intelligenza artificiale è suscettibile di distorsioni che spesso sono rilevabili solo con attente analisi. La – purtroppo poca – letteratura sul tema ci racconta che esistono ben 23 tipologie di bias che in un modo o nell’altro possono incidere su un progetto di AI e distorcerne i risultati. Insomma, la faziosità è propria dell’essere umano e le macchine possono moltiplicarla, il che rende ancora più difficile individuare ed eliminare l’errore nell’algoritmo: il pregiudizio è stato ignorato a lungo e nel frattempo la quantità di dati analizzata è aumentata costantemente.

Consapevolezza e inclusione

La prima cosa che dobbiamo fare noi che ci occupiamo di AI è sviluppare un’adeguata consapevolezza del problema; solo così potremo progettare, sviluppare, implementare e governare un’intelligenza artificiale più etica e inclusiva. Un’AI che noi chiamiamo fair (giusta) che si impegni a testare il suo algoritmo in un regime simile a quello in cui verrà utilizzato nel mondo reale e che dimostri di funzionare per tutti. Per fare questo, però, è necessario utilizzare dei data set che siano realmente rappresentativi, correggendo le enormi distorsioni in quelli attuali e investendo per crearne di nuovi per quei gruppi e quelle comunità che sono stati finora ignorati; inoltre è necessario sviluppare dei protocolli che controllino in maniera rigorosa tutto il ciclo della produzione di una soluzione di AI, a partire dalla scelta dei modelli fino all’effettiva distribuzione a chi la utilizzerà, nel proprio lavoro o nella vita quotidiana.

Il tema dei bias nell’AI è per noi molto importante perché offre grandi opportunità. È una grande occasione per ridurre l’effetto dei pregiudizi umani e per evitare che si perpetuino. Abbiamo margine per scoprire soluzioni migliori, ma per poter cogliere queste opportunità è necessario uscire dal campo informatico e dell’ingegneria: il tema è complesso e va affrontato a 360°. C’è bisogno di una maggior partecipazione da parte di tutti per riuscire a rendere l’intelligenza artificiale più fair: chi la sviluppa deve impegnarsi a farlo nel migliore dei modi ma anche chi la utilizza deve chiedere a gran voce che questa tecnologia sia realmente giusta.

A cura di Denis Peroni, Chief Architect Officer e Co-fondatore di Indigo.ai