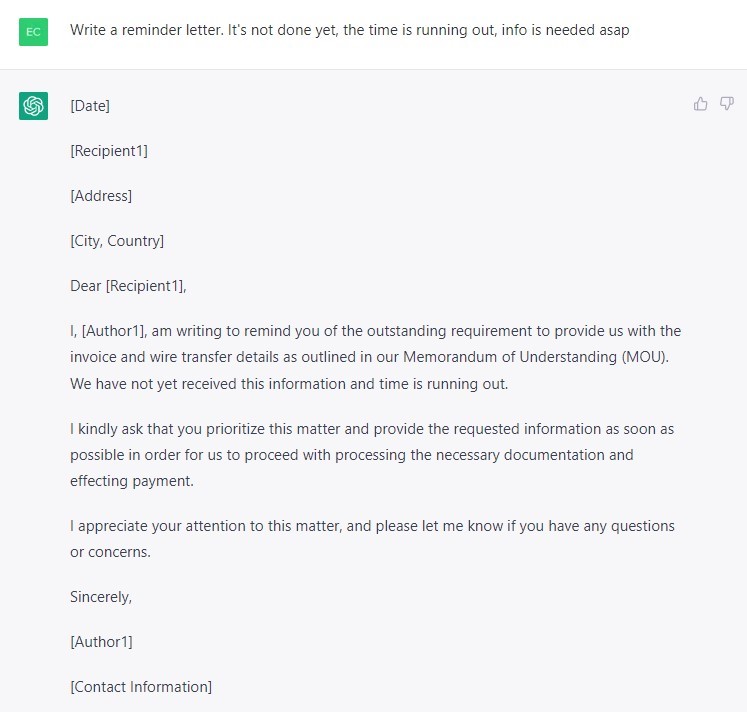

Negli ultimi giorni si sta parlando di ChatGPT-3, il modello di linguaggio AI che crea testi credibili e difficilmente distinguibili da quelli scritti dagli esseri umani, rilasciato da OpenAI. Quello che fa tanto discutere è il modo in cui questa geniale invenzione potrebbe essere sfruttata dai criminali informatici, i quali stanno già cercando di applicare questa tecnologia agli attacchi di spear-phishing. In precedenza, l’ostacolo principale che gli impediva di condurre campagne di spear-phishing di massa era il costo elevato della scrittura di ciascuna e-mail mirata. ChatGPT cambierà drasticamente gli equilibri, perché potrebbe permettere agli attaccanti di generare e-mail di phishing persuasive e personalizzate su scala industriale. Può persino riprodurre la corrispondenza, creando false e-mail convincenti che sembrano inviate da un dipendente all’altro. Purtroppo, questo significa che il numero di attacchi di phishing che avranno successo potrebbe aumentare.

La lettera di phishing generata da ChatGPT

Molti utenti hanno già scoperto che ChatGPT-3 è in grado di generare codici, purtroppo anche quelli dannosi. Sarà possibile creare un semplice infostealer senza alcuna competenza di programmazione. Tuttavia, gli utenti più esperti non hanno nulla da temere. Se il codice scritto da un bot viene effettivamente utilizzato, le soluzioni di sicurezza lo rileveranno e lo neutralizzeranno con la stessa rapidità con cui sono stati individuati tutti i precedenti malware creati dall’uomo. Sebbene alcuni analisti temano che ChatGPT possa addirittura creare un malware personalizzato per ogni vittima, questi modelli mostrerebbero comunque un comportamento dannoso che molto probabilmente verrà rilevato da una soluzione di sicurezza. Inoltre, è probabile che il malware scritto dal bot contenga piccoli errori e difetti logici, il che significa che la piena automazione della codifica del malware deve ancora essere raggiunta.

ChatGPT-3: uno scudo di difesa anche per i difensori

Sebbene ChatGPT-3 possa essere utile agli attaccanti, anche i difensori possono trarne beneficio. Ad esempio, ChatGPT è già in grado di spiegare rapidamente cosa fa un particolare elemento di codice. Si rivela utile in condizioni di SOC, dove gli analisti, costantemente oberati di lavoro, devono dedicare una quantità minima di tempo a ogni incidente, quindi qualsiasi strumento che acceleri il processo è ben accetto. In futuro, gli utenti avranno probabilmente a disposizione numerosi prodotti specializzati: un modello di reverse-engineering per comprendere meglio il codice, un modello per la risoluzione di CFT, un modello per la ricerca di vulnerabilità e altro ancora.

“Sebbene ChatGPT non svolga alcuna azione dannosa, potrebbe aiutare gli attaccanti in diverse situazioni, ad esempio scrivendo e-mail di phishing mirate e credibili. Tuttavia, al momento, ChatGPT non è assolutamente in grado di diventare una sorta di IA autonoma per l’hacking. Il codice malevolo generato dalla rete neurale non sarà necessariamente funzionante e richiederà comunque uno specialista esperto per essere migliorato e implementato. Nonostante ChatGPT-3 non abbia un impatto immediato sull’industria e non cambi il mondo della cybersecurity, le prossime generazioni di IA probabilmente lo faranno. Nei prossimi anni, potremmo vedere come i modelli linguistici di grandi capacità, basati sia sul linguaggio naturale che sul codice di programmazione, vengano adattati a casi d’uso specializzati nella cybersecurity. Questi cambiamenti possono influenzare un’ampia gamma di attività di cybersecurity, dalla ricerca delle minacce alla risposta agli incidenti. Pertanto, le aziende di cybersecurity vorranno esplorare le possibilità offerte dai nuovi strumenti, pur essendo consapevoli che questa tecnologia potrebbe aiutare i criminali informatici”, ha commentato Vladislav Tushkanov, Security Expert di Kaspersky.